Поисковые системы хранят в базе бесконечное множество страниц с сайтов, но некоторые из них не включают в поиск, так как считают их малоценными, маловосстребованными – не несущими полезной информации для пользователей.

Например, Яндекс извещает, что

Малоценной страница может быть признана:

- если она является полным или частичным дублем;

- не содержит видимый роботу контент.

Маловостребованной, если робот решит, что:

- в поиске нет запросов, на которые данная страница могла бы ответить (даже если страница без ошибок в коде и содержит контент).

В обоих случаях страница может быть исключена из поиска. Давай разберем подробнее эти определения.

Малоценные страницы на сайте

Полные или частичные дубли на примере интернет-магазина – карточки товаров одного вида очень похожи и могут различаться лишь картинкой, парой фраз или предложений. Робот читает всю страницу целиком, все сквозные блоки (шапка, меню сайдбар, подвал) и из-за очень низкой уникальности признает ее дублем. Из поиска страница удаляется, а сайт получает минус к репутации.

Нет контента или мало контента – иногда на странице размещают только видео, фото, картинки без «живого» текста, или текста очень мало, 1-2 предложения, или текст размещен на картинке (афиши, объявления). А бывает и так, что вебмастера делают на будущее и публикуют пустыми целые разделы с пустыми (только заголовки) страницами. Потом они про них забывают, и образуется малоценная страница без контента.

Маловостребованные страницы

– например, когда заголовки и мета-теги прописаны неправильно или некорректно по отношению к самому тексту страницы. Другими словами – в заголовке, в h1 есть ключевое слово, а в тексте оно не упоминается вообще ни разу. Или когда автор придумывает от себя ключевую фразу к публикации, а такой запрос (по статистике) ни кто и никогда из пользователей интернета не задавал. ПС может посчитать, что информация никому не интересна и удалит страницу из выдачи.

Минусы для сайта от малоценных страниц

1. Снижается авторитет сайта.

Если на сайте много подобных страниц, в совокупности с другими техническими ошибками, авторитет площадки может снизиться.

2. Ухудшаются поведенческие факторы

Пользователь заходит на малоценную страницу и не находит нужную информацию. Он быстро закрывает сайт, что повышает показатель отказов — ухудшает поведенческие факторы.

3. Происходит каннибализация ключевых слов

Простыми словами – использования одних и тех же ключевых слов на разных страницах. Такие страницы будут конкурентами внутри ресурса, а это грозит негативными последствиями для видимости сайта в поиске.

4. Малоценные или маловостребованные страницы снижают краулинговый бюджет сайта

Краулинговый бюджет – это лимит, который выдается каждому сайту на индексацию. Предположим, что вашему сайту назначен лимит на индексацию 100 страниц. На сайте 50 этих «плохих» страниц. Если поисковый робот обойдет много страниц с низкой ценностью, он может и не добраться до важных, хороших страниц.

Как найти, определить малоценные страницы

C помощью сервиса Яндекс.Вебмастер

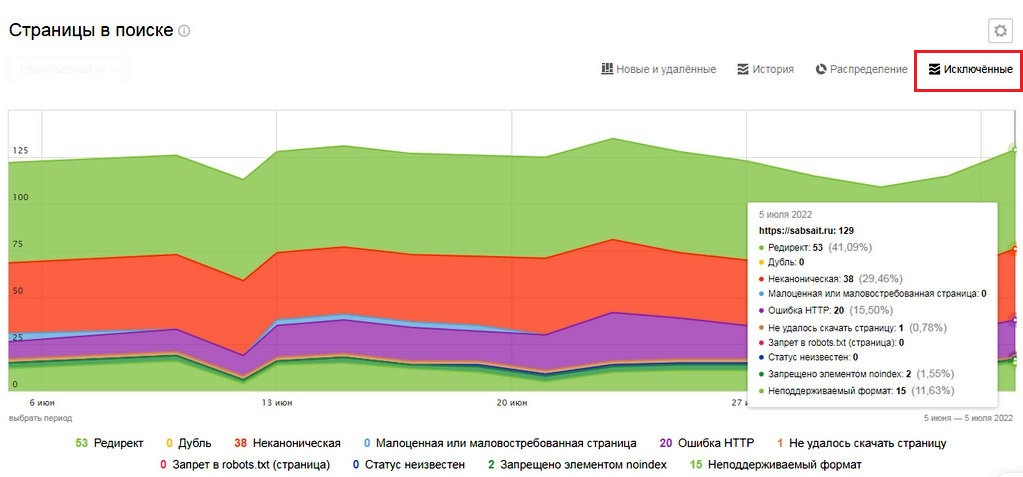

- Открываем Яндекс.Вебмастер и в левом меню переходим в раздел «Индексирование – Страницы в поиске».

- В верхнем меню выбираем «Исключенные»

По графику несложно разобраться, а при наведении курсора – отобразятся данные на определенную дату

По малоценным страницам смотрим процент.

- если показатель от 0 до 20% — это в пределах нормы;

- если от 20 до 30% — пересматриваем проблемные страницы и отправляем их на «Переобход страниц»;

- показатель свыше 40% – делаем сами или заказываем технический аудит.

Отслеживаем отчеты Яндекс.Вебмастра.

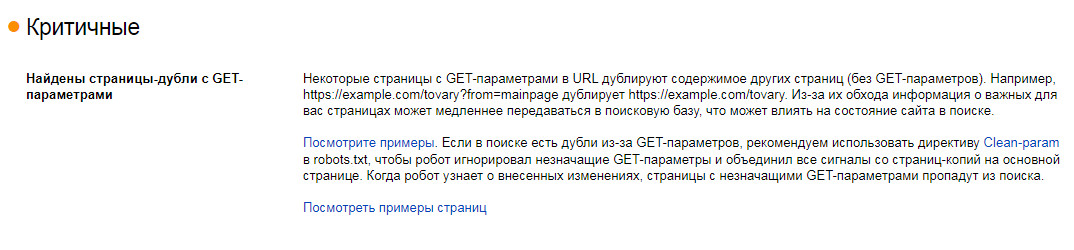

Если пришло такое сообщение «Некоторые страницы с GET-параметрами в URL дублируют содержимое других страниц (без GET-параметров)» — смотрим примеры страниц и решаем, что с ними делать:

- технические страницы и некоторые дубли можно закрыть через файл robots.txt или через метатег noindex;

- для страниц с параметрами (например, страницы сортировки) прописать rel=«canonical» или Clean-param в robots.txt

С помощью программы Screaming Frog SEO Spider

Если вы с ней незнакомы — в ближайшее время расскажу на сайте, а если уже пользовались – просканируйте свой сайт.

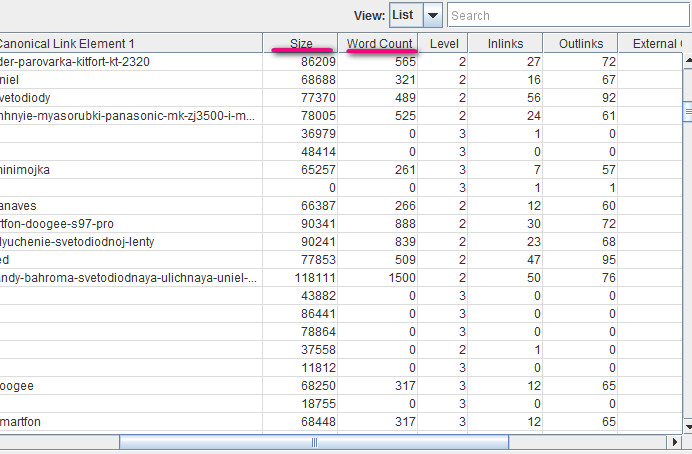

По результату можно отсортировать страницы по Word Count (количество слов) или Size (размер страницы):

Смотрим, что это за страницы предполагая — чем меньше страница весит, тем меньше ее ценность и объем контента, так же и с количеством слов.

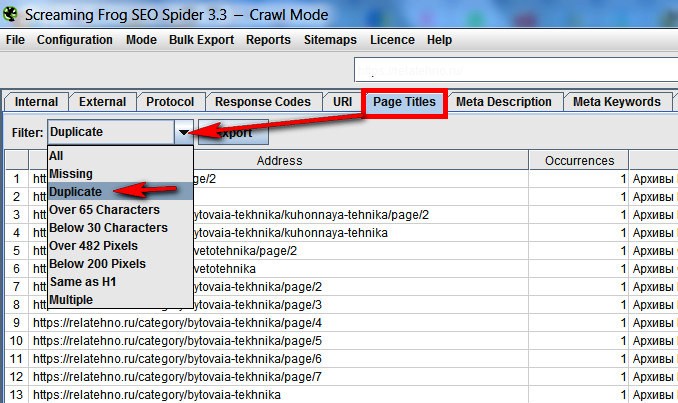

Там же можно проверить дублирующиеся теги, выявляя похожие страницы. Вкладка Title и в выпадающем меню Duplicate

С помощью Яндекс.Метрики или Google Analytics

Ищем страницы с плохими поведенческими факторами, один из вариантов – сортировка страниц по проценту отказов

Варианты исправления малоценных страниц

После выявления или получения уведомления о таких некачественных страницах, не следует сразу удалять, закрывать или переадресовывать их – нужно разобраться, выяснить причину.

Дубли страниц – там, где частично или полностью повторяется контент. Если их немного, можно перенаправить редиректом 301 через файл .htaccess или плагинами, со временем проиндексируется новый документ, а старый уйдет из поиска. Если дублей много – удаляем те, куда нет сторонних ссылок, а оставшиеся делаем каноническими.

Находим дубли Яндекс.Вебмастером (смотрите выше), программой Screaming Frog SEO Spider, и в Google Search Console — вкладка «Оптимизация Html» — список с потенциальными дублями – одинаковыми мета-описаниями.

Страницы с GET-параметрами (внутренний поиск, сортировка, фильтры) – лучший вариант прописать Clean-param или rel=«canonical» в robots.txt.

Технические страницы можно закрыть в файле robots.txt

Например: Disallow: *apply*

Это закроет страницы типа /catalog/rozetki_vyklyuchateli/legrand_plexo/filter/clear/apply/. Только желательно проверить наличие трафика на эти страницы, чтобы не потерять его.

Заключение

Работа над малоценными страницами не обязывает к большим затратам, но может принести неплохие результаты, особенно на больших сайтах.

Если статья была интересна для вас - ей можно поделиться

Интересная информация.Надо будет заняться проверкой.